图像特征分析是图像处理的重要研究方向之一。采用合适的图像特征检测方法,使其能在图像特定区域提取出合理的相应的图像特征,并且对光照强度、视角或尺度具有较强的鲁棒性,是图像特征分析的难点。本文从图像特征分析入手,研究单帧图像中物体的轮廓检测算法。

基于图像特征分析的轮廓检测方法包括图像局部检测子方法,对某一像素周围区域量化以检测边界信息。例如Roberts算子[1]、Sobel算子[2]和Prewitt算子[3]等是通过对图像的模拟色彩通道使用局部微分滤波器作卷积。Marr和Hildreth算子[4]是用高斯模板的拉普拉斯变换(Laplacian of Gaussian,LoG)做边缘分割。考虑图像在不同尺度、不同方向滤波器下响应值的图像特征描述子也是研究点之一,如文献[5-6]中使用正交的对偶对称滤波器,设计基于方向的图像能量描述子。

有的研究者在检测轮廓时,考虑色彩和纹理信息。文献[7-8]提出利用梯度算子对亮度、色彩和纹理通道进行检测,并把它们作为逻辑回归分类器的输入以预测边界强度。Dollar等[9]提出了一种提升式边界学习算法,概率提升树(probabilistic boosting tree)[10],从多种图像特征中学习合适的边界分类器。有的研究者将图像分割成小的目标块[11],而后融合图像块内的亮度、色彩和纹理等特征,使用聚类算法对局部特征进行量化。而后将聚类中心作为图像的基元,采用核密度估计等方式来评价最优基元以作为图像的轮廓。

传统的二维图像(或视频图像帧)由于其自身的局限性,在轮廓提取上遇到瓶颈,而彩色-深度(RGB-D)图像能获取图像(或视频图像帧)的深度信息,在物体轮廓提取方面具有巨大的潜力[12]。随着深度传感器价格的下降和计算机视觉技术的发展,RGB-D深度摄像机取得了商业上的成功,并在研究领域得到了广泛的研究,其被应用到场景理解、三维重建、姿态识别、目标识别和动作识别等研究课题中。价格相对低廉的深度信息采集传感器(如Kinect)的使用,使得可以用深度信息处理物体轮廓提取的问题。

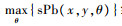

1 轮廓特征提取在轮廓特征提取部分,本文参考了Martin[7]和Arbelaez[13]等的工作。 Martin等[7]定义了边界后验概率(Pb)函数,用于预测在任意一个图像像素(x,y)角度为θ的边界线的后验概率。他通过测量局部图像的亮度、颜色和纹理信息的差异来得到Pb函数。而本文基于RGB-D图像,增加了深度信息,得到更全面的Pb函数。同时,采用多尺度的Pb算子,再基于此采用锐化的手段来提高轮廓准确度。

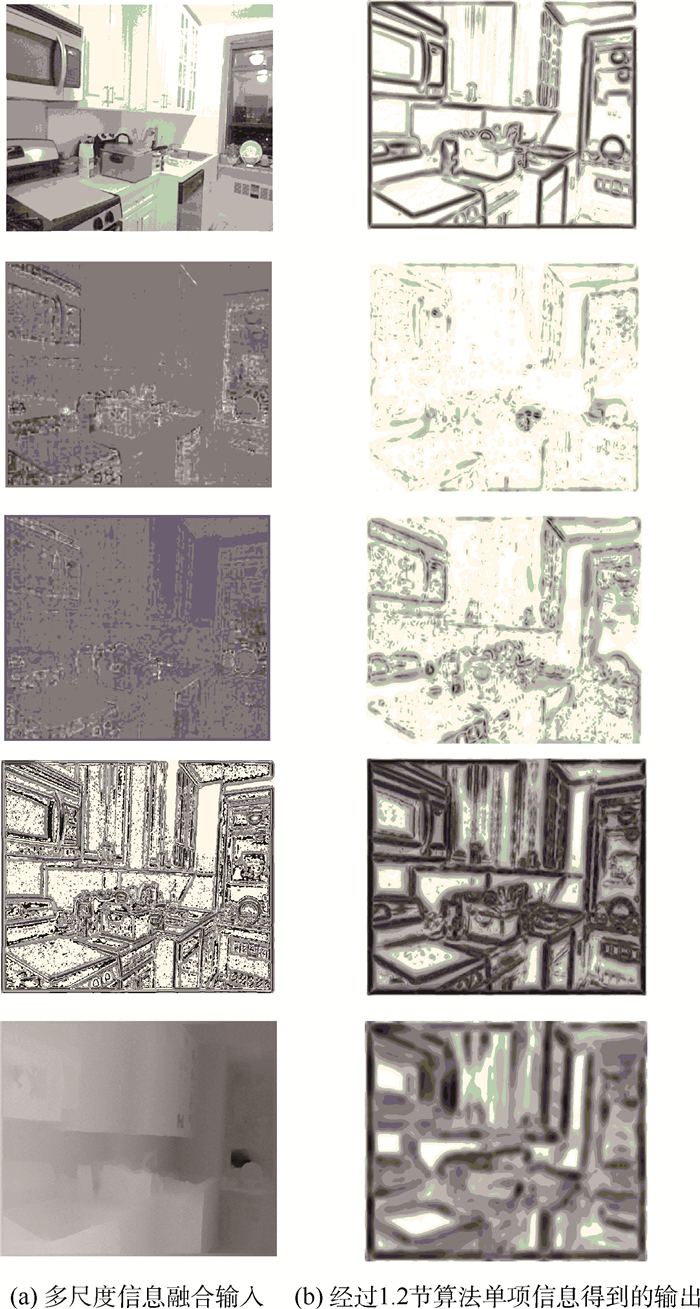

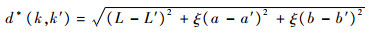

1.1 检测亮度、色彩、纹理和深度的梯度信息Pb算子计算图像的方向性梯度信号G(x,y,θ)。对于图像中的某一像素点(x,y)做某一半径的圆,区域内的像素被角度为θ的直径分为两部分。对这两块半圆内的像素,做它们的强度直方图[13]。在像素点(x,y)的梯度量为

|

(1) |

式中:i为像素点强度值,求和范围由图像像素值的范围决定;g(i)和h(i)为半圆内的强度直方图。以每一个目标像素点为中心,施加一个方向为θ的局部二维窗口。在这个二维窗口内计算每个像素点的响应值,代替原有灰度信息,得到在某一像素点的不同方向的梯度值。图像轮廓是像素点的一种表现形式,而梯度值是对像素邻域内建模的好方法,有很强的鲁棒性。对于RGB-D图像,本文提出设计Pb算子的方向性梯度量有5个特征,分别是亮度色彩相关的L、 a和b特征,体现空间域特性的纹理特征和相对深度特征。

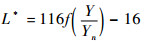

1.1.1 Lab色彩空间为了减小RGB颜色数据所受的采集设备影响,采用Lab色彩空间来进行计算。Lab色彩空间与RGB空间的换算公式如下。

RGB空间先变换为XYZ空间:

|

(2) |

式中:Rsrgb、Gsrgb和Bsrgb代表RGB图像3个通道的值;X、Y、Z代表着CIE XYZ空间的值。对某一通道的值K,当K>0.040 45时,有g(K)=[(K+a)/(1+a)]γ,其中a=0.055,γ=2.4;而当K≤0.040 45时,则g(K)=K/12.92。

XYZ空间再换算至Lab空间:

|

(3) |

|

(4) |

|

(5) |

式中:L*、a*和b*为计算得到的Lab色彩空间的值;Xn、Yn和Zn则为固定的参考值。对于某一变量t,当

|

| 图 1 RGB图像转换为Lab色彩空间示例 Fig. 1 Example of RGB image changed to Lab color space |

提取图像的纹理基元特征。先把图像转化为灰度图像,并使用8个方向的Gabor小波和DOG特征子提取出不同方向的纹理信息,总共有17个高斯滤波结果,图 2为滤波器的示例图。

|

| 图 2 滤波器示例图 Fig. 2 Example of filter maps |

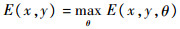

使用这17种高斯滤波后,每个像素点得到一个17维响应矩阵。对这些矩阵使用K-means(Km=32)算法聚类。聚类的中心定义为纹理基元,每个像素点得到值为[1, 32]的纹理标示。计算结果为一幅每个像素点都有[1,K]范围内的一个整数值的图像,这个值即是由K-means聚类算法得到的基元标示。得到的纹理特征矩阵T如图 3所示。

|

| 图 3 RGB图像得到的纹理特征 Fig. 3 Texture feature of RGB image |

由RGB-D数据得到的深度信息矩阵为每个像素点相对摄像头的深度值,设定最低深度为零海平面,从而得到整张图像的相对深度信息,如图 4所示。根据深度信息可由梯度计算公式计算深度特征的梯度矩阵。

|

| 图 4 深度图 Fig. 4 Depth image |

深度梯度表现图像相对于摄像头深度值的不连续性。通过深度信息,能方便地分辨出处于图像中不同景深的物体。当背景颜色与物体颜色相近时,深度梯度能弥补RGB数据的不足。

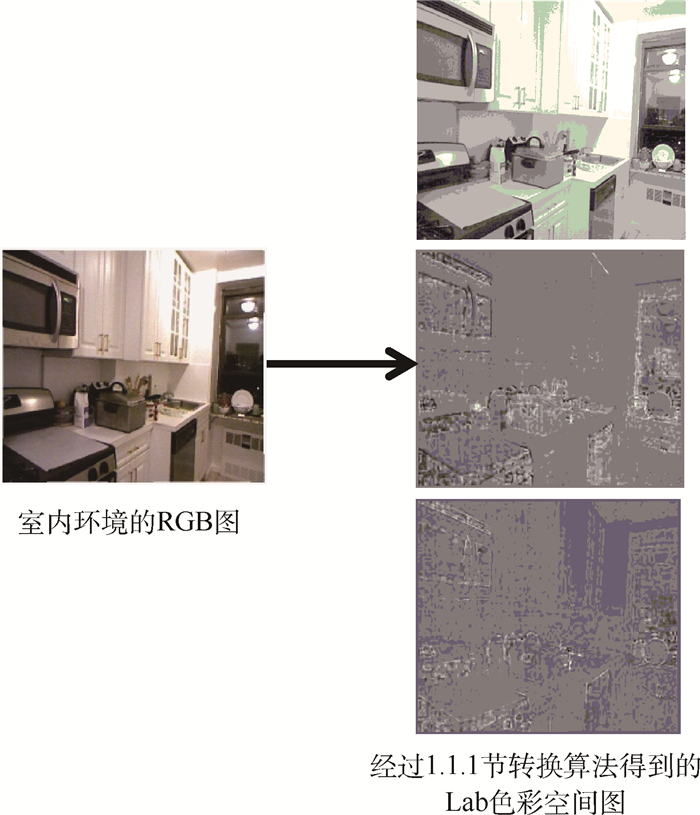

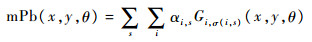

1.2 多尺度信息融合本节介绍一种基于Pb算子的多尺度信息融合。为了更好检测轮廓,定义了3种计算梯度量的圆半径。对每种特征都有3种尺度[σ/2,σ,2σ]。对于不同的特征可以采用不同的尺度值。将这些处理后的梯度量叠加得到多尺度的方向性信息,如式(6)所示:

|

(6) |

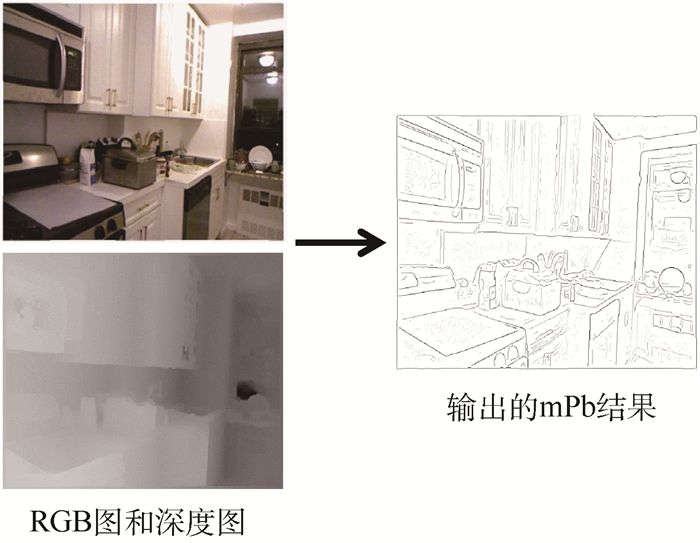

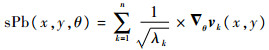

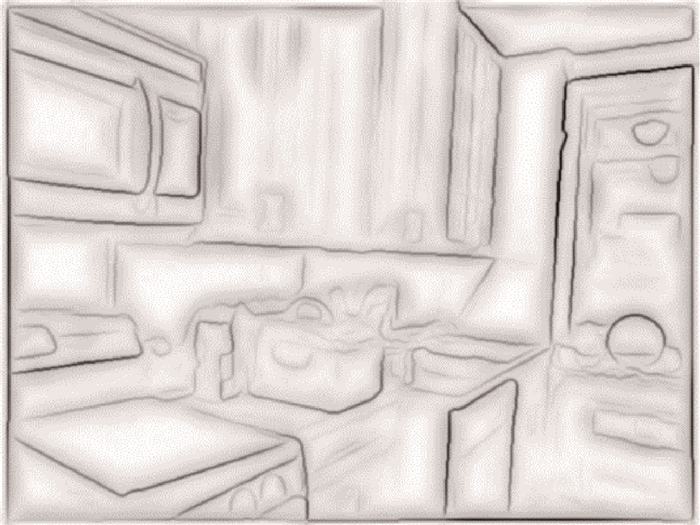

式中:s代表3种不同尺度;i代表5种特征(亮度L,色彩a,色彩b,纹理T 和深度D);θ在[0,π]内等间隔若干方向;Gi,σ(i,s)(x,y,θ)即1.1节所提到的在任一像素点(x,y)的一定半径的圆,区域内的像素被角度为θ的直径分为两部分,对这两块半圆内的像素,计算梯度值;变量αi,s衡量的是每一种梯度量的贡献度。多尺度信息融合结果如图 5所示,图 5(a)为多尺度信息融合输入的信息,图 5(b)为单项信息得到的输出,mPb算法结果如图 6所示。将mPb在多个方向上的最大响应值作为每个像素点的边界强度衡量参数:

|

| 图 5 多尺度信息融合结果 Fig. 5 Results from multi-scale cues fusion |

|

| 图 6 mPb算法结果 Fig. 6 Results obtained by mPb algorithm |

|

(7) |

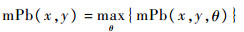

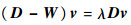

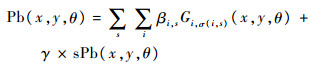

由于1.2节多尺度信息融合mPb的结果对图像细节边缘部分模糊,因此需要采取锐化措施,通过基于谱后验概率(sPb)的计算结果,弥补边缘的信息损失。图像锐化(image sharpening)的本质是增强图像原有轮廓的边缘部分,弥补图像的边缘缺失及在边缘处发生跳变的部分,从而使图像更加清晰。本文使用两个像素点间最大的mPb值,构建一个对称的稀疏关系矩阵W,作为谱聚类的输入,从而完成图像锐化操作。

以像素点i为圆心、固定的r值为半径得到圆域,圆域内任意点i与j的关系矩阵:

|

(8) |

式中:p为像素点i与j的连线上任意一点,半径为r; 常数ρ为放大系数。定义

该方法与直接采用mPb相比,可以避免区域过平滑化,防止物体因背景不同而被截断。将每个特征矩阵作不同方向上的Gabor滤波,得到基于方向性的特征矩阵{▽θvk(x,y)},即各个方向上都存在特定方向上的保留特征,综合起来相当于保留了整张图像的特征,从而避免过平滑问题。之后利用谱分解得到对尖锐边缘敏感的sPb特征:

|

(9) |

式中 :λ为特征矩阵的特征值。sPb的结果如图 7所示。

|

图 7

|

mPb信息和sPb信息代表着图像的不同特性,前者集中于整体大型边界,后者集中于尖锐的轮廓。把这两种信息以一定的权重进行线性叠加,能够综合两种信息的优点,可以得到高效的全局轮廓后验边界概率(gPb):

|

(10) |

从而可以得到较好的轮廓清晰度。gPb的结果如图 8所示,由本节算法得到。

|

| 图 8 gPb结果 Fig. 8 Image of gPb |

由实验结果可以看出,多尺度信息mPb与图像锐化后的sPb的结合,能得到比较清晰的图像边缘和较好的物体轮廓。但gPb中的图像轮廓并不是完全闭合的。实际结果中存在能描述出物体轮廓,但是无法形成闭合的轮廓曲线。而闭合的轮廓曲线,才是物体分割所真正需要的部分。下节将讨论利用分水岭算法等方法获取闭合的轮廓曲线。

2 图像分割由第1节结果可以看出,利用gPb方法得到轮廓通常是不闭合的,从而无法把图像分成不同区域。本节讨论在第1节gPb未闭合的轮廓基础上,使用分水岭算法等来恢复闭合轮廓,同时还能保证在第1节中的边界质量。

2.1 方向性的分水岭算法在第1节中,从不同的角度出发对图像特征进行计算和融合,那么不同角度下得到的分水岭也是不一样的,所以使用不同角度下的数据进行选择提取。令函数E(x,y,θ)代表图像中的某一边界在像素点(x,y)方向θ上为真实边界的概率。计算

基础的分水岭算法[14]有一定缺陷,简单地通过像素点的E(x,y)平均值评价每一段片段容易造成虚假边界。为了修正这个问题,方向性分水岭算法保证边界片段的强度与片段K0上的概率E(x,y,θ)信号的一致性。通过把分水岭弧用直线近似代替,从几何学的角度检测某一片段上的每个像素的方向性。递归地细分每段弧,直到直线段连上了它的终点。通过这种近似的评价方法,得到弧上一点离直线段的最大距离,作为直线段长度的一段。由此得到了尺度不变形的细分弧段。对细分弧段上每一个像素点(x,y)分配一个对应直线段的方向ο(x,y)∈(0,π)。而后,使用基于方向性的轮廓检测子输出结果E(x,y,θ),分配给弧上每一个像素点(x,y)一个边界强度E(x,y,ο(x,y))。最后,根据像素点的平均边界强度对每一段上0的原始分水岭片段赋予权重。

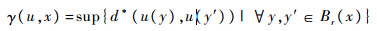

2.2 超度量轮廓图利用分水岭算法得到的图像轮廓并不具有确定性,采用超度量的轮廓图(ultrametric contour maps)[15]提升轮廓检测的结果,其基本思想将轮廓层次化。底层次的层级能针对较弱强度的边界进行处理,但同时也会造成过分割的图像结果;而上层的层级更针对强边界,但同时会导致分割缺失。所以需要在底层和上层层级系统中寻找平衡点,即把图像理解成一个多种尺度空间下的分割结果的集合,再从中选择合理的轮廓。采取的方法是,定义一个使用原始图像的色彩信息的距离、对比区域间的对比度。将色彩图像转移至Lab色彩空间,由毕达哥拉斯公式评价两种颜色的距离。两种颜色k=(L,a,b)和k′=(L′,a′,b′)之间的距离定义为

|

(11) |

通过Lab空间的颜色表达,灰度图像相对的参数ξ=0,而一般情况下的Lab空间ξ=1。为了提高边界检测的准确性,利用局部比较函数,来对某一点进行评估:

|

(12) |

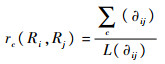

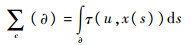

式中:Br(x)表示一个以x为球心的、r为半径的欧式空间内的球。计算共有轮廓的平均局部对比:

|

(13) |

式中:L(∂)代表轮廓∂的长度;

|

(14) |

相互关联的超度量轮廓图能保留原始边界的位置。而后利用区域融合贪婪算法对RGB-D图像的gPb输出结果进行处理,得到超度量轮廓图,如图 9所示。

|

| 图 9 超度量轮廓图 Fig. 9 Ultrametric contour map |

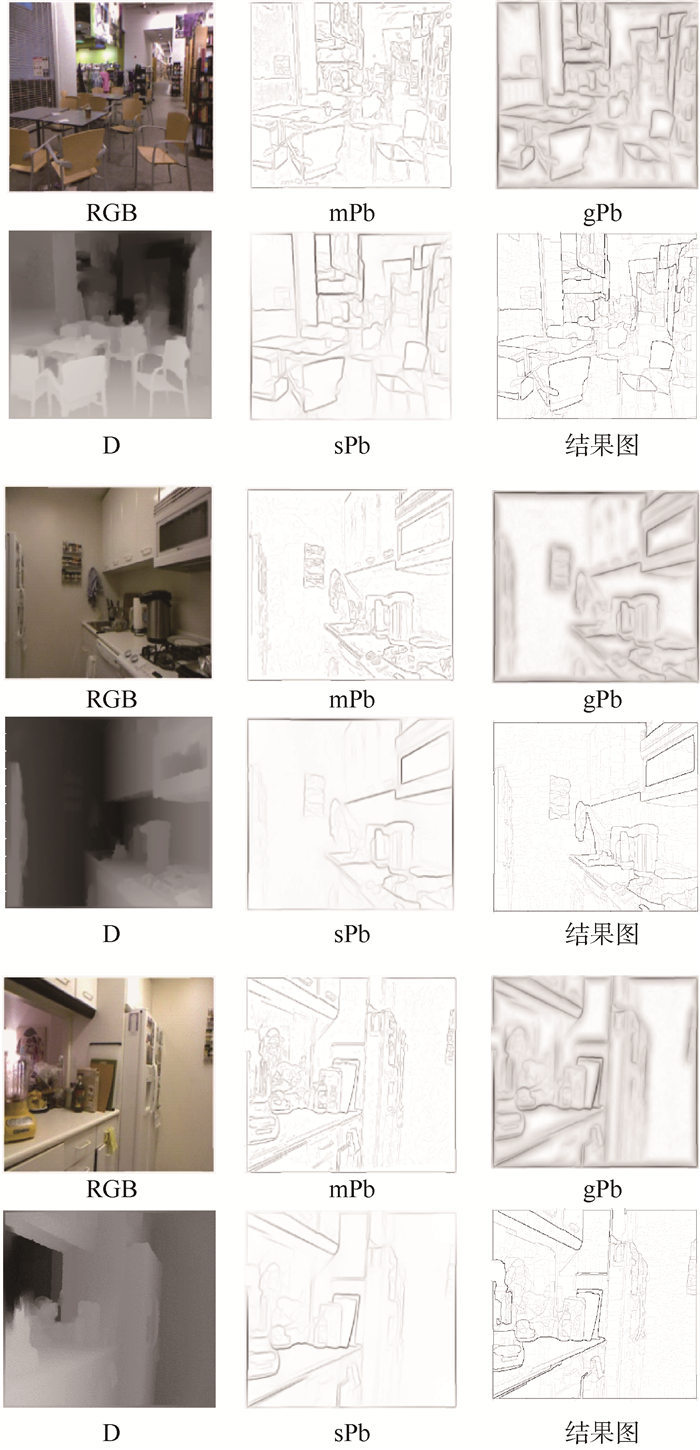

本文所提的实验算法实现步骤如算法1所示。根据本文中所叙述的方法,对NYU Depth Dataset V2数据库中的RGB-D室内图像进行处理,得到的结果如图 10所示。

|

| 图 10 实验结果 Fig. 10 Experimental results |

实验算法实现步骤如下。

算法1 基于图像特征分析的物体轮廓提取。输入量:室内RGB-D图像。

1) 数据预处理,把RGB数据换算至LAB空间,从图像中提取出纹理特征,深度数据换算至相对深度。

2) 对预处理后的5组数据(亮度L、色彩a、 色彩b、 纹理T和深度D)作梯度量运算。

3) 使用mPb算子对5组梯度量运算,得到多尺度下多方向的信息融合mPb结果。

4) 使用sPb算子对5组梯度量运算,得到不同梯度方向下的sPb结果。

5) 综合mPb和sPb算子结果,得到不同梯度方向下的gPb结果。

6) 基于超度量距离对gPb结果采用分水岭算法,得到闭合的超度量轮廓图,即物体实际轮廓。

本实验结果与使用其他物体轮廓提取算法结果对比,如图 11所示。图中可以看出Sobel无法提取出有效边界,Laplace算子能提取出大部分边界,但是无法形成有效闭合轮廓。因为引入了深度数据,相比图 11(b)中的参考文献实验,在颜色相近的不同深度物体间边缘处理有一定改进,例如在此幅图像的右半部分的橱柜和餐具的轮廓显得更加清晰。

|

| 图 11 实验结果对比 Fig. 11 Experimental results comparison |

1) 本文对室内彩色、深度(RGB-D)图像的颜色与深度特征进行分析,利用全局轮廓后验边界概率方法结合超度量图算法提取物体轮廓。

2) 实验结果表明,全局轮廓后验边界概率方法对室内RGB-D图像数据有较好的准确性,能提取出大致的物体轮廓,融合深度数据能加强实验结果。

3) 基于方向性的分水岭算法和超度量距离改进后,能成功融合区域,得到超度量轮廓图,即完整的物体轮廓。

4) 在后续的研究中,将尝试更多的数据库来验证此算法的有效性,探索有效利用深度信息的方法,并探讨与实测物体尺寸进行比较以客观评价算法分割精度的方法。

致谢

感谢王欢女士在本文准备过程中的协助工作。

| [1] | ROBERTS L G. Machine perception of three-dimensional solids[J]. Optical and Electro-optical Information Processing, 1963, 20 : 31 –39. |

| [2] | DUDA R O, HART P E. Pattern classification and scene analysis[M]. New York: Wiley-Interscience Publication, 1973 : 10 -12. |

| [3] | PREWITT J. Object enhancement and extraction[J]. Picture Processing and Psychopictorics, 1970, 10 (1) : 15 –19. |

| [4] | MARR D, HILDRETH E. Theory of edge detection[J]. Royal Society of London Proceedings, 1980, 207 (1167) : 187 –217. DOI:10.1098/rspb.1980.0020 |

| [5] | PERONA P,MALIK J.Detecting and localizing edges composed of steps,peaks and roofs[C]//Proceedings 3rd IEEE International Conference on Computer Vision (ICCV 1990).Piscataway,NJ:IEEE Press,1990:52-57. |

| [6] | MORRONE M C, OWENS R A. Feature detection from local energy[J]. Pattern Recognition Letters, 2014, 6 (5) : 303 –313. |

| [7] | MARTIN D R, FOWLKES C C, MALIK J. Learning to detect natural image boundaries using local brightness,color,and texture cues[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2004, 26 (5) : 530 –549. DOI:10.1109/TPAMI.2004.1273918 |

| [8] | GUPTA S,ARBELÁEZ P,MALIK J.Perceptual organization and recognition of indoor scenes from RGB-D images[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR 2013).Piscataway,NJ:IEEE Press,2013:564-571. |

| [9] | DOLLAR P,TU Z,BELONGIE S.Supervised learning of edges and object boundaries[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR 2006).Piscataway,NJ:IEEE Press,2006:1964-1971. |

| [10] | TU Z W.Probabilistic boosting-tree:Learning discriminative models for classification,recognition,and clustering[C]//Proceedings 10 th IEEE International Conference on Computer Vision (ICCV 2005).Piscataway,NJ:IEEE Press,2005:1589-1596. |

| [11] | FELZENSZWALB P F, HUTTENLOCHER D P. Efficient graph-based image segmentation[J]. International Journal of Computer Vision, 2004, 59 (2) : 167 –181. DOI:10.1023/B:VISI.0000022288.19776.77 |

| [12] | SILBERMAN N,HOIEM D,KOHLI P,et al.Indoor segmentation and support inference from RGBD images[C]//Proceedings of the 12th European Conference on Computer Vision (ECCV 2012).Heidelberg:Springer-Verlag,2012,Part 5:746-760. http://cn.bing.com/academic/profile?id=125693051&encoded=0&v=paper_preview&mkt=zh-cn |

| [13] | ARBELAEZ P, MAIRE M, FOWLKES C, et al. Contour detection and hierarchical image segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2011, 33 (5) : 898 –916. |

| [14] | NAJMAN L, SCHMITT M. Geodesic saliency of watershed contours and hierarchical segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 1996, 18 (12) : 1163 –1173. |

| [15] | AEBELAEZ P.Boundary extraction in natural images using ultrametric contour maps[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition Workshop.Piscataway,NJ:IEEE Press,2006:182-189. |