-

摘要:

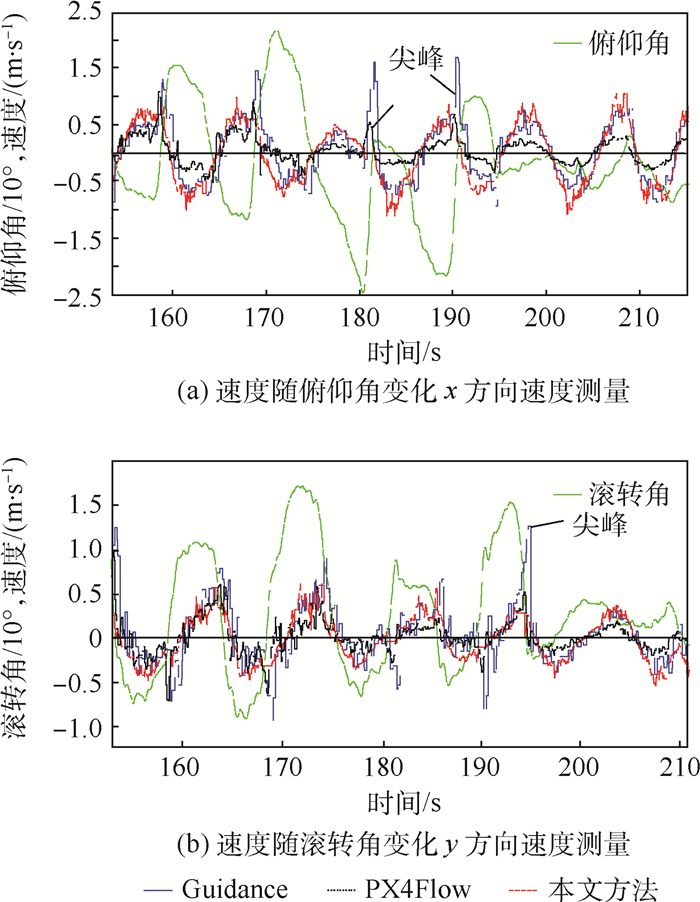

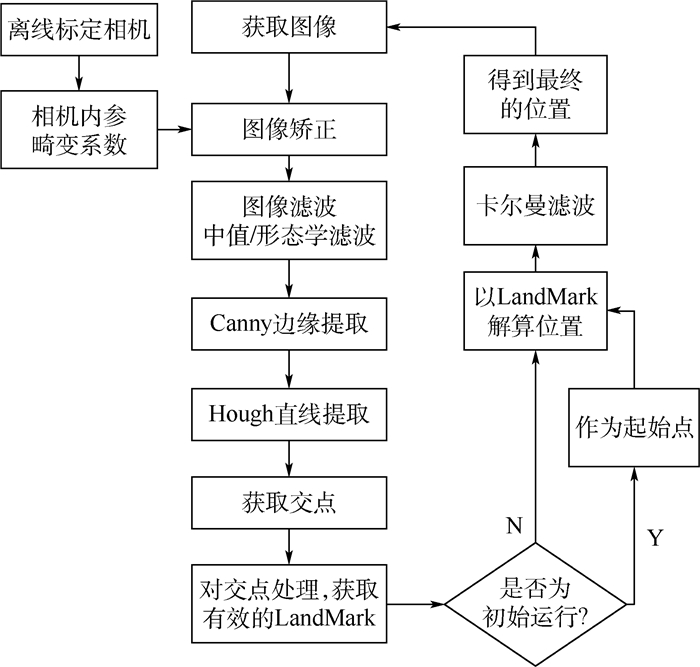

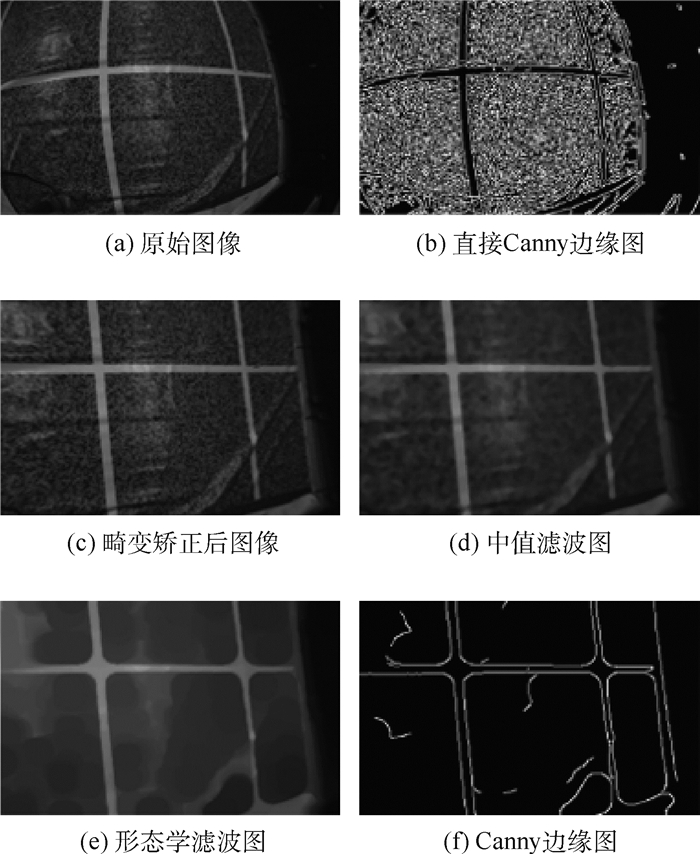

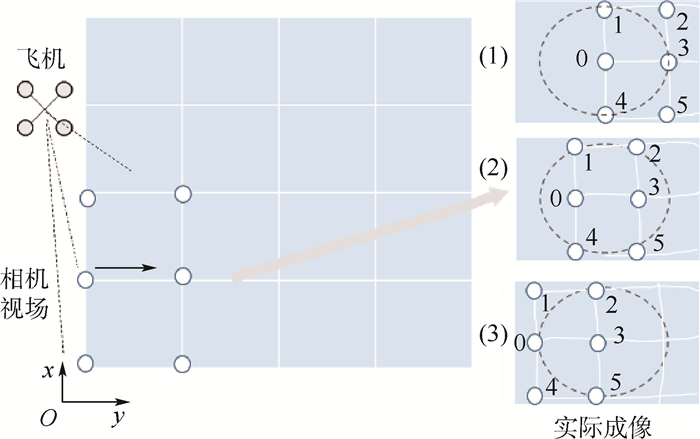

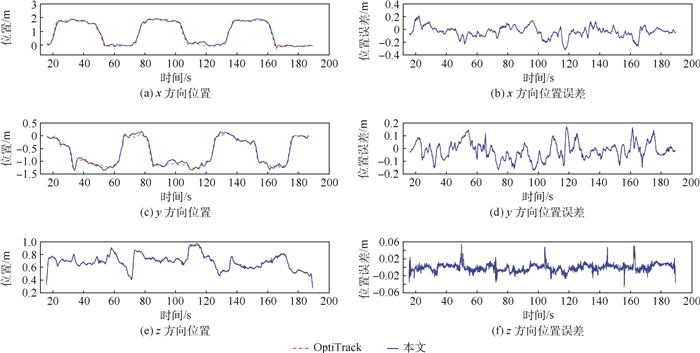

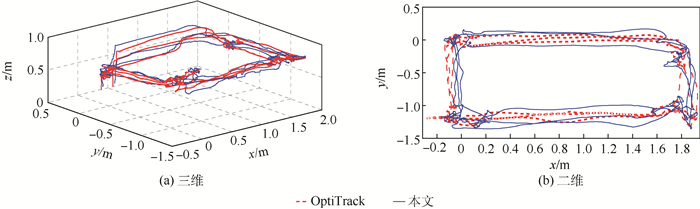

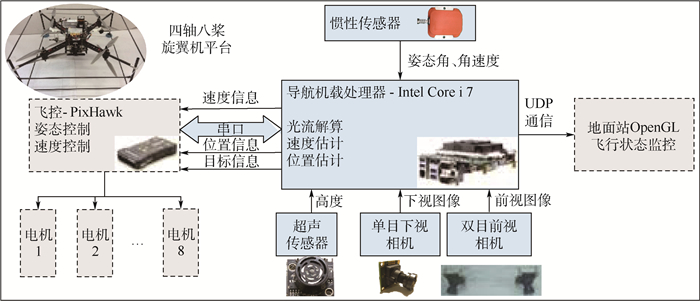

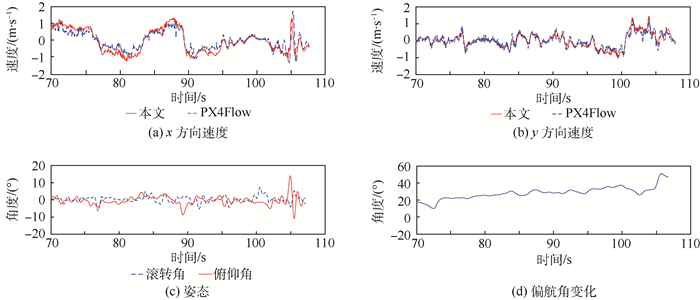

针对室内无卫星定位下的无人机自主导航问题,提出了一种融合惯导、光流和视觉里程计的组合导航方法。在速度估计上,采用基于ORB特征的光流法,该方法可以实时地估计出无人机的三轴线速度信息。方法采用基于特征点的稀疏光流,对金字塔Lucas-Kanade光流法进行了改进,采用前后双向追踪和随机采样一致的方法提高特征点追踪精度。在位置估计上,采用视觉/惯导融合的视觉里程计,以人工图标法为主,融合视觉光流信息和惯导数据实现无人机定位。通过与运动捕捉系统的定位信息、Guidance和PX4Flow导航模块的测速信息进行对比,以及实际的飞行测试,验证本文方法的可行性。

Abstract:A new integrated navigation method based on inertial sensor, optical flow and visual odometry is proposed for self-navigation indoor in GPS-denied environment. An ORB optical flow based method is also proposed for estimating real-time three-axis velocity of the UAV. The algorithm improves the traditional pyramid Lucas-Kanade method using sparse optical flow based on feature points. The tracking of feature points is made more accurate by applying forward-backward tracking and random sampling consensus strategies. For position estimation, a visual odometry method with integrated vision/inertial navigation is adopted, which uses the artificial icon method, visual optical flow information and inertial navigation data. Finally, the velocity and position estimations from the proposed method are validated via actual flight test and via comparison with velocity measurement information from a PX4Flow module and a Guidance module and with locating information from movement capture system.

-

Key words:

- UAV /

- vision navigation /

- optical flow /

- ORB features /

- multi-sensor fusion

-

[1] SHEN S J.Autonomous navigation in complex indoor and outdoor environments with micro aerial vehicles[D].Philadelphia:University of Pennsylvania, 2014. [2] 吴琦, 蔡志浩, 王英勋.用于无人机室内导航的光流与地标融合方法[J].控制理论与应用, 2015, 32(11):1511-1517.WU Q, CAI Z H, WANG Y X.Optical flow and landmark fusion method for UAV indoor navization[J].Control Theory & Applications, 2015, 32(11):1511-1517(in Chinese). [3] LI P, LAMBERT A.A monocular odometer for a quadrotor using a homogra-phy model and inertial cues[C]//IEEE Conference on Robotics and Biomimetics.Piscataway, NJ:IEEE Press, 2015:570-575. [4] 叶长春. IARC第7代任务中定位与目标跟踪方法研究[D]. 杭州: 浙江大学, 2016.YE C C.Research on localization and object tracking for the IARC mission7[D].Hangzhou:Zhejiang University, 2016(in Chinese). [5] MUR-ARTAL R, MONTIEL J M M, TARDOS J D.ORB-SLAM:A versatile and accurate monocular SLAM system[J].IEEE Transactions on Robotics, 2015, 31(5):1147-1163. doi: 10.1109/TRO.2015.2463671 [6] LEUTENEGGER S, FURGALE P, RABAUD V, et al.Keyframe-based visual-inertial SLAM using nonlinear optimization[C]//Robotics:Science and Systems, 2013:789-795. [7] CHAO H, GU Y, GROSS J, et al.A comparative study of optical flow and traditional sensors in UAV navigation[C]//American Control Conference(ACC).Piscataway, NJ:IEEE Press, 2013:3858-3863. [8] MAMMARELLA M, CAMPA G, FRAVOLINI M L, et al.Comparing optical flow algorithms using 6-dof motion of real-world rigid objects[J].IEEE Transactions on, Systems, Man, and Cybernetics, Part C:Applications and Reviews, 2012, 42(6):1752-1762. doi: 10.1109/TSMCC.2012.2218806 [9] DJI Innovations.PHANTOM 4 user's manual V1.2[EB/OL].(2016-12-23) [10] Hover Camera 2016[EB/OL].(2016-12-23) [11] RUBLEE E, RABAUD V, KONOLIGE K, et al.ORB:An efficient alternative to SIFT or SURF[J].Proceedings, 2011, 58(11):2564-2571. [12] ROSTEN E, DRUMMOND T.Machine learning for high-speed corner detection[C]//European Conference on Computer Vision.Berlin:Springer-Verlag, 2006:430-443. [13] CALONDER M, LEPETIT V, STRECHA C, et al.BRIEF:Binary robust independent elementary features[C]//European Conference on Computer Vision.Berlin:Springer-Verlag, 2010:778-792. [14] LOWE D G.Distinctive image features from scale-invariant keypoints[J].International Journal of Computer Vision, 2004, 60(2):91-110. doi: 10.1023/B:VISI.0000029664.99615.94 [15] BAY H, TUYTELAARS T, GOOL L V.SURF:Speeded up robust features[J].Computer Vision & Image Understanding, 2006, 110(3):404-417. [16] CHUM O, MATAS J, KITTLER J.Locally optimized RANSAC[J].Lecture Notes in Computer Science, 2003, 2781:236-243. doi: 10.1007/b12010 [17] HONEGGER D, MEIER L, TANSKANEN P, et al.An open source and open hardware embedded metric optical flow cmos camera for indoor and outdoor applications[C]//International Conference on Robotics and Automation.Piscataway, NJ:IEEE Press, 2013:1736-1741. [18] HARTLEY R I, ZISSERMAN A.Multi-view geometry in computer vision[M].Cambrige:Cambridge University Press, 2004:239-247. -

下载:

下载: